Google s’attaque à un nouveau défi digne de la science-fiction : faire tourner l’intelligence artificielle depuis l’orbite terrestre. Le géant américain a révélé Project Suncatcher, une initiative expérimentale visant à installer des centres de données alimentés à l’énergie solaire… dans l’espace. Une ambition technologique qui pourrait, selon ses chercheurs, redéfinir la manière dont l’IA consomme l’énergie à l’échelle mondiale.

Des data centers IA en orbite à 650 kilomètres d’altitude

L’objectif de Project Suncatcher est de concevoir une infrastructure de calcul d’intelligence artificielle capable de fonctionner depuis l’espace, entièrement grâce à l’énergie solaire. Selon la présentation officielle de Google, le projet prévoit de déployer des constellations compactes de satellites équipés de puces Tensor Processing Units (TPU). Ce sont les « accélérateurs d’IA » maison utilisés par Google pour entraîner et faire tourner ses modèles. Ce réseau de satellites, interconnectés par des liaisons optiques sans fil (lumière ou lasers), serait potentiellement capable, à terme, de rivaliser avec la puissance des data centers terrestres.

Les ingénieurs de Google expliquent que ces satellites seraient placés sur une orbite basse, dite « héliosynchrone », qui leur permettrait de rester presque en permanence exposés au Soleil. « Dans la bonne orbite, un panneau solaire peut être jusqu’à huit fois plus productif que sur Terre », souligne l’entreprise. Alimentés de manière quasi continue, ces serveurs spatiaux éviteraient ainsi les interruptions nocturnes ou saisonnières qui limitent les installations terrestres. Le tout en réduisant le besoin en batteries.

Pour valider cette approche, Google prévoit le lancement de deux prototypes en 2027, en collaboration avec la société Planet Labs. Ces premiers tests devront vérifier le comportement des modèles et TPU en orbite, la résistance des composants aux radiations et la stabilité des connexions inter-satellites. Les premières expérimentations, partagées dans un article de recherche, ont déjà montré des résultats prometteurs. La puce TPU « Trillium », soumise à un rayonnement, n’a présenté de défaillances (mineures) qu’à partir d’une dose cumulée trois fois supérieure à une mission spatiale de 5 ans.

Coût, haut débit… Des analyses et essais prometteurs

Si l’idée d’un cloud spatial fait rêver, elle pose d’immenses défis techniques. Les équipes de Google ont dû développer des modèles physiques pour contrôler des constellations de satellites volant à quelques centaines de mètres les uns des autres, afin d’assurer une communication fluide à très haut débit. Des tests en laboratoire ont déjà atteint une vitesse de 1,6 térabit par seconde entre deux transcepteurs ; un débit comparable à celui des meilleures interconnexions terrestres.

Mais l’une des clés du projet repose aussi sur la réduction des coûts de lancement. Historiquement, envoyer du matériel en orbite coûtait plusieurs milliers de dollars par kilo. Or, Google estime que ce prix, actuellement de 1 500 $/kg sur une fusée Falcon Heavy, pourrait tomber sous les 200 $/kg d’ici le milieu des années 2030, grâce à la démocratisation des lanceurs réutilisables comme ceux de SpaceX. À cette échéance, un data center spatial pourrait être compétitif par rapport à une infrastructure terrestre, compte tenu du coût par kilowatt.

« Si les besoins en IA continuent de croître et que la demande en énergie suit la même trajectoire, cette approche a un potentiel immense de développement », déclarait Travis Beals, directeur du programme « Paradigms of Intelligence » chez Google.

Le géant de la tech admet toutefois qu’il reste des obstacles majeurs à franchir : la gestion thermique, la fiabilité des systèmes à long terme en orbite et la communication à très haut débit vers le sol.

Nvidia, Starlink via SpaceX : les projets IA concurrents dans l’espace

Google n’est pas seul à viser le cloud spatial. La start-up Starcloud, en partenariat avec Nvidia, prévoit de lancer dès le mois de novembre 2025, les premiers GPU H100 dans l’espace. Le projet final consiste en des data centers plus proches de ceux sur Terre. Assemblé à partir de conteneurs modulaires, remplis de baies de serveurs, le centre de données doit, à terme, atteindre un objectif de 5 GW, avec des équipements s’étendant sur un carré de 4 km de côté.

De son côté, Elon Musk a déclaré que SpaceX et Starlink, fournisseur Internet par satellite, pourraient eux aussi se lancer dans la création de data centers en orbite, via leurs satellites V3. Par ailleurs, Jeff Bezos, le patron d’Amazon, a récemment prédit un déploiement d’installations plus performantes que sur Terre dans les 10 à 20 prochaines années.

La société Lonestar Data Holdings pousse encore plus loin le concept, en souhaitant carrément installer des serveurs sur la Lune. Un premier centre de données de la taille d’un livre y a été envoyé et testé avec succès, avec l’aide de SpaceX et Intuitive Machines, en début d’année.

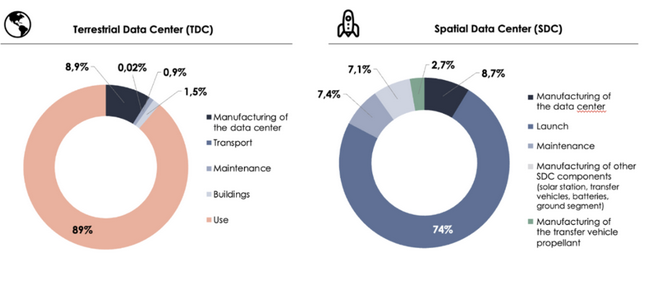

Mais ces projets ne font pas l’unanimité. Une étude financée par l’Union européenne a remis en question le bénéfice carbone net des data centers spatiaux, soulignant que les émissions de CO₂ liées aux lancements pourraient annuler les gains énergétiques réalisés en orbite.

Les chercheurs y précisent que ce modèle ne devient plus intéressant que les installations terrestres que « si et seulement si les lanceurs sont réutilisables et émettent en moyenne moins de 370 kg de CO₂ par kilogramme de charge utile sur toute leur durée de vie. »

Avec Project Suncatcher, Google renoue avec sa tradition des « moonshots » ; ces projets visionnaires à la frontière entre innovation et utopie. Après les voitures autonomes ou l’informatique quantique, le groupe veut désormais tester les limites du calcul distribué en réseau, dans l’espace. Si les défis techniques et économiques sont immenses, la perspective d’un cloud alimenté en continu par l’énergie solaire, affranchi des contraintes terrestres, pourrait à terme redéfinir les fondations de l’infrastructure numérique mondiale. Un pari audacieux, certes, mais fidèle à l’esprit des ingénieurs de la Silicon Valley.

Et vous, pensez-vous que les data centers spatiaux peuvent apporter une solution aux besoins en énergie de l’intelligence artificielle, et à son impact écologique ?

Certains liens de cet article peuvent être affiliés.

C’est fascinant de penser à des data centers dans l’espace ! Cela pourrait vraiment transformer notre consommation d’énergie. J’espère que les défis techniques seront surmontés pour réaliser cette vision inspirante.

Le projet de Google semble une belle promesse pour l’avenir. Imaginez un cloud alimenté par le soleil, flottant parmi les étoiles, libérant notre technologie des contraintes terrestres. Inspirez-moi !

Wow, l’idée de data centers dans l’espace est incroyable ! Si ça peut réduire notre impact écologique, ce serait génial pour l’IA. Hâte de voir les résultats des prototypes en 2027 !

Le concept de data centers spatiaux est fascinant ! Si Google réussit, cela pourrait révolutionner notre façon de consommer l’énergie pour l’intelligence artificielle. En attendant, reste à voir les défis à relever.