Des chercheurs du Massachusetts Institute of Technology (MIT) ont mis au point un système combinant intelligence artificielle et robotique capable de créer des objets physiques à partir de simples commandes vocales. Baptisée « speech-to-reality », cette approche vise à rendre la fabrication plus rapide et accessible, y compris pour des utilisateurs sans expertise en conception ou en robotique.

Un robot qui traduit la parole en objet physique

Pilotée intégralement par l’IA, l’invention du MIT permet littéralement de « faire apparaître » des objets à partir d’un énoncé verbal. Lorsqu’un utilisateur prononce une commande comme « Je veux un tabouret simple », le système traite d’abord la requête via une reconnaissance vocale couplée à un grand modèle de langage (LLM). Une IA générative 3D produit ensuite un maillage numérique de l’objet. Puis, celui-ci est converti en composants modulaires assemblables grâce à un algorithme de « voxelisation », qui traduit l’objet en couches 2D superposées.

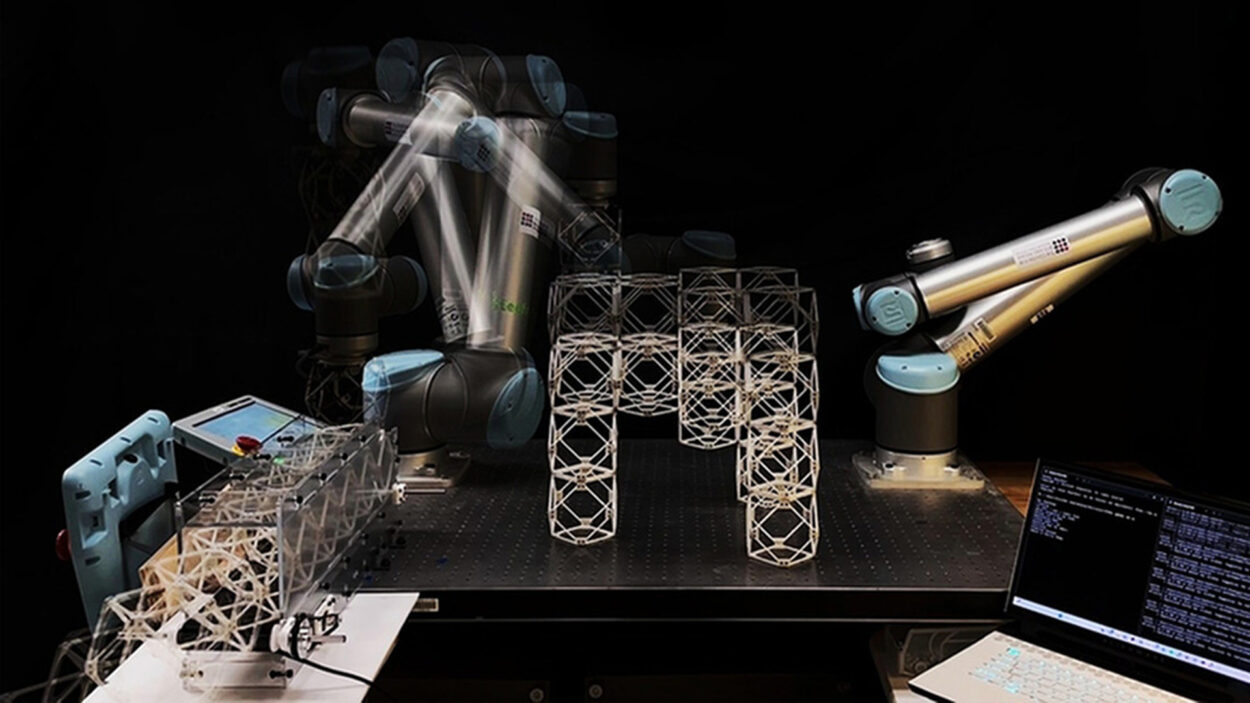

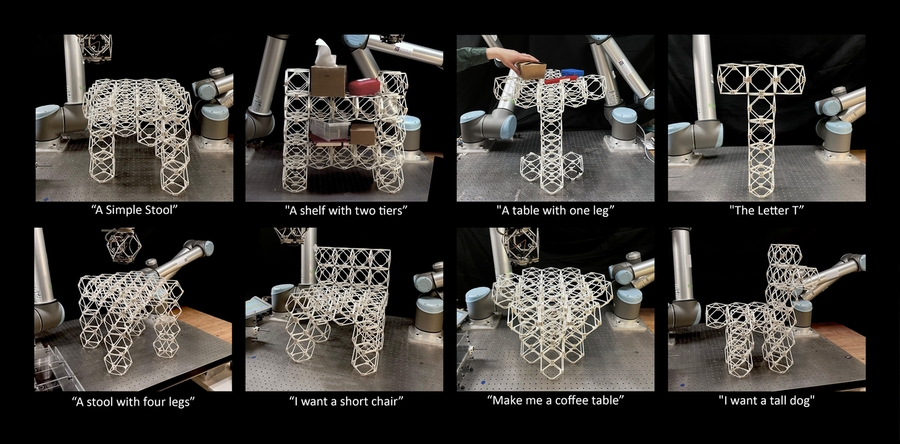

Le robot, un bras articulé monté sur une table, assemble alors physiquement l’objet à partir des éléments préfabriqués, notamment des cubes légers et empilables, connectés magnétiquement. À ce stade, les chercheurs ont déjà produit des tabourets, des chaises, des étagères, une table et des objets décoratifs comme une statue de chien. Selon les équipes du MIT, ce processus permet de fabriquer des objets en quelques minutes seulement, contre des heures ou des jours pour des méthodes comme l’impression 3D.

Alexander Htet Kyaw, doctorant au MIT et chercheur principal du projet, décrit ce dispositif comme « une interface entre les humains, l’IA et les robots pour co-créer le monde qui nous entoure ».

« Imaginez un scénario dans lequel vous dites “je veux une chaise”, et où, en cinq minutes, une chaise physique se matérialise devant vous », ajoute Kyaw avec enthousiasme.

Une approche combinant IA générative et raisonnement géométrique

Contrairement aux systèmes classiques de conception assistée par ordinateur (CAO), souvent complexes et peu adaptés au prototypage rapide, la solution du MIT repose sur une chaîne d’outils IA interconnectés. Le système combine reconnaissance vocale, modèles de langage, génération de maillages 3D, voxelisation, traitement géométrique et planification robotique.

Un point clé du projet réside dans l’adaptation des modèles génératifs aux contraintes du monde réel. Les chercheurs soulignent que les maillages 3D produits par l’IA sont généralement inexploitables tels quels pour l’assemblage robotisé. Leur système modifie donc automatiquement les conceptions pour tenir compte de paramètres comme le nombre de composants, les porte-à-faux, la connectivité ou encore la stabilité.

« L’un des plus grands défis consistait à s’assurer que le système respecte les contraintes de fabrication », explique Alexander Htet Kyaw.

« Le système doit garantir que les objets peuvent être assemblés sans collisions, qu’ils tiennent debout sous l’effet de la gravité et qu’ils puissent être démontés et réutilisés. » Cette combinaison entre modèles d’IA, raisonnement géométrique et retours issus d’expériences d’assemblage réelles constitue l’un des apports majeurs du projet.

Accessibilité, durabilité et perspectives d’évolution pour le MIT

En utilisant le langage naturel et les commandes vocales, le système s’adresse à des personnes sans compétences en modélisation 3D ou en programmation robotique. Selon une étude de Jabra et la LSE, la voix devrait d’ailleurs devenir le principal mode d’interaction avec les IA d’ici 2028. Une approche dont Gradium, une start-up française spécialisée dans les modèles vocaux, espère être le « champion mondial » d’ici quelques années.

« Tôt ou tard, nous voulons pouvoir communiquer et parler avec un robot et un système d’IA de la même manière que nous parlons entre nous pour fabriquer des choses ensemble. Notre système est une première étape vers la réalisation de cet avenir », explique Kyaw.

Les composants modulaires, conçus pour être assemblés, démontés et réutilisés, permettent également de limiter les déchets liés à la fabrication. Cette logique ouvre la voie à des usages évolutifs : transformer un meuble en un autre lorsque les besoins changent, ou produire localement des objets sans recourir à des chaînes logistiques lourdes.

Les chercheurs envisagent déjà d’améliorer la capacité portante des structures, notamment en remplaçant les connexions magnétiques par des fixations plus robustes, et d’étendre le système à des robots mobiles pour construire des structures de plus grande taille. À plus long terme, l’équipe explore aussi l’ajout de commandes gestuelles pour simplifier encore l’interaction humain-machine, de matériaux comme du verre et du métal ou encore d’autres types de pièces comme des engrenages et des charnières.

« Notre objectif est de réduire drastiquement les barrières d’accès aux outils de conception. », résume Randall Davis, professeur au MIT. « Nous avons montré qu’il est possible d’utiliser l’IA générative et la robotique pour transformer des idées en objets physiques de manière rapide, accessible et durable. »

Avec ce système « speech-to-reality », les chercheurs du MIT démontrent qu’il est désormais possible de passer directement d’une description verbale à un objet tangible en quelques minutes. En combinant IA générative, raisonnement géométrique et assemblage robotisé, ils esquissent une nouvelle étape vers la fabrication à la demande, plus accessible et potentiellement plus durable, qui pourrait transformer en profondeur notre rapport à la conception d’objets physiques.

Certains liens de cet article peuvent être affiliés.