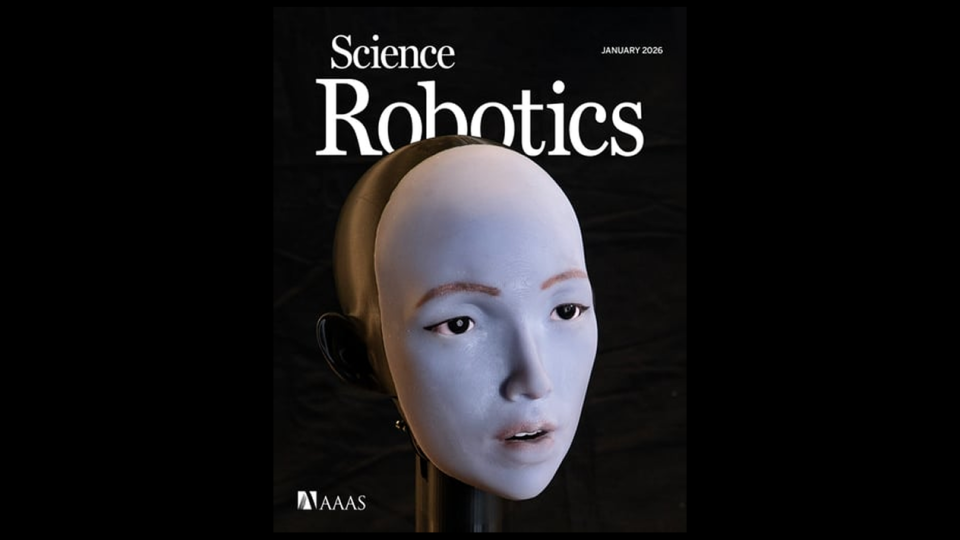

Développé par des chercheurs de l’université Columbia, le robot Emo franchit un nouveau cap dans la robotique humanoïde. Capable initialement de reproduire des expressions faciales humaines, il peut désormais synchroniser précisément les mouvements de ses lèvres sur des mots parlés ou chantés, après l’avoir appris en regardant YouTube. Une avancée majeure qui fait espérer une communication plus naturelle entre hommes et machines.

La synchronisation labiale du robot Emo, obtenue par observation

La principale nouveauté apportée par Emo réside dans sa capacité à coordonner les mouvements de ses lèvres avec des sons vocaux, dans plusieurs langues. Une vidéo diffusée par l’équipe de Columbia montre le robot parlant le français, anglais, espagnol, allemand, chinois, japonais ou encore le coréen, avec une correspondance visible entre l’audio et les mouvements faciaux.

Comme l’explique dans son communiqué l’école d’ingénierie de Columbia, ce résultat nécessite à la fois un matériel spécialisé et une modélisation fine de la dynamique des lèvres, directement liée aux séquences de sons et de phonèmes.

Côté matériel, la prouesse repose notamment sur un visage flexible en silicone, animé par 26 micromoteurs capables d’agir rapidement et de manière silencieuse. Une apparence anthropomorphe que l’on retrouve chez d’autres robots, tel que les modèles hyperréalistes de AheadForm.

« Il n’y a pas d’avenir où tous ces robots humanoïdes n’auront pas de visage. Et lorsqu’ils en auront enfin un, ils devront pouvoir bouger leurs yeux et leurs lèvres correctement, sinon ils resteront à jamais étranges », explique Hod Lipson, directeur du laboratoire à l’origine du projet.

Un apprentissage de l’IA inspiré du développement humain

Plutôt que de programmer des règles, les chercheurs ont privilégié une approche d’apprentissage par l’observation, en plusieurs étapes. A l’instar de Figure 03 de Figure AI, le robot s’appuie en effet sur un modèle « vision-langage-action » (VLA), qui combine perception visuelle et compréhension du langage pour générer des actions.

Dans un premier temps, Emo a été placé devant un miroir pour comprendre comment ses commandes motrices modifiaient la forme de son visage. Il a ainsi réussi à reproduire des expressions humaines. Une méthode similaire à l’apprentissage d’un enfant, qui rappelle les modèles d’intelligence spatiale et visuelle, développés notamment par le Français Yann LeCun. Ensuite, Emo a visionné de nombreuses vidéos de personnes parlant ou chantant, notamment issues de YouTube, afin d’associer des sons à des mouvements de lèvres.

« Quelque chose de magique se produit lorsqu’un robot apprend à sourire ou à parler simplement en regardant et en écoutant des humains », explique Yuhang Hu, responsable de l’étude. « Plus le robot observe les humains converser, plus il deviendra capable d’imiter les expressions faciales nuancées auxquelles nous pouvons nous connecter émotionnellement ».

Le langage des robots humanoïdes : limites techniques et enjeux sociétaux

Malgré ces avancées, les chercheurs reconnaissent que la synchronisation n’est pas encore parfaite, car certaines sonorités posent toujours problème. « Nous avons rencontré des difficultés particulières avec les sons durs comme le ‘B’ et avec les sons impliquant une contraction des lèvres, comme le ‘W’ », précise Hod Lipson.

Le chercheur estime toutefois que ces limites devraient s’atténuer avec plus d’entraînement et les futurs progrès technologiques. De plus, les équipes sont enthousiastes à l’idée de pouvoir utiliser le robot avec des LLM, les grands modèles de langage. L’objectif de cette association est d’améliorer les interactions de l’humanoïde avec les gens, et ainsi de réduire l’effet « vallée de l’étrange » (« uncanny valley » en anglais), ce malaise suscité par les machines imitant l’humain, mais de manière imparfaite.

« Lorsque la capacité de synchronisation labiale est combinée à une IA conversationnelle telle que ChatGPT ou Gemini, l’effet ajoute une toute nouvelle profondeur à la connexion que le robot établit avec l’humain », affirme Yuhang Hu.

Les chercheurs reconnaissent néanmoins les risques liés à des interactions hommes-robots naturelles. « Ce sera une technologie puissante. Nous devons procéder lentement et avec prudence, afin de pouvoir en récolter les fruits tout en minimisant les risques », insiste Hod Lipson.

Avec Emo, les chercheurs de Columbia tendent à montrer que l’expression faciale et la synchronisation labiale pourraient devenir des briques essentielles de la robotique humanoïde. En rapprochant la communication des codes humains, cette avancée ouvre la voie à des interactions plus naturelles, tout en posant de nouvelles questions éthiques sur l’apparence et la place des robots dans la société.

Certains liens de cet article peuvent être affiliés.