Microsoft Research vient de présenter Rho-alpha, un nouveau modèle d’IA destiné à la robotique, pensé pour améliorer l’autonomie des machines. Rho-alpha se distingue par son intégration du toucher, en plus de la vision et du langage, et par sa capacité à apprendre en continu grâce aux retours humains. Une approche qui vise en priorité les tâches de manipulation bimanuelle, parmi les plus complexes en robotique.

Rho-alpha de Microsoft, un modèle d’IA physique centré sur la manipulation

Rho-alpha est présenté comme le premier modèle robotique issu directement de la famille de modèles « vision-langage » Phi de Microsoft. Son objectif principal est de traduire des instructions en langage naturel en signaux de contrôle pour des robots capables de manipuler des objets avec leurs deux bras. Contrairement aux systèmes industriels classiques, basés sur des scripts rigides, le modèle est conçu pour fonctionner dans des contextes moins prévisibles.

Rho-alpha s’inscrit dans le champ de l’IA physique, un courant qui cherche à rapprocher les capacités de raisonnement des modèles d’IA de leur interaction avec le monde réel. « L’émergence des modèles vision-langage-action (VLA) pour les systèmes physiques permet aux machines de percevoir, raisonner et agir avec une autonomie croissante aux côtés des humains dans des environnements bien moins structurés », explique Ashley Llorens, vice-président et directeur général de Microsoft Research Accelerator.

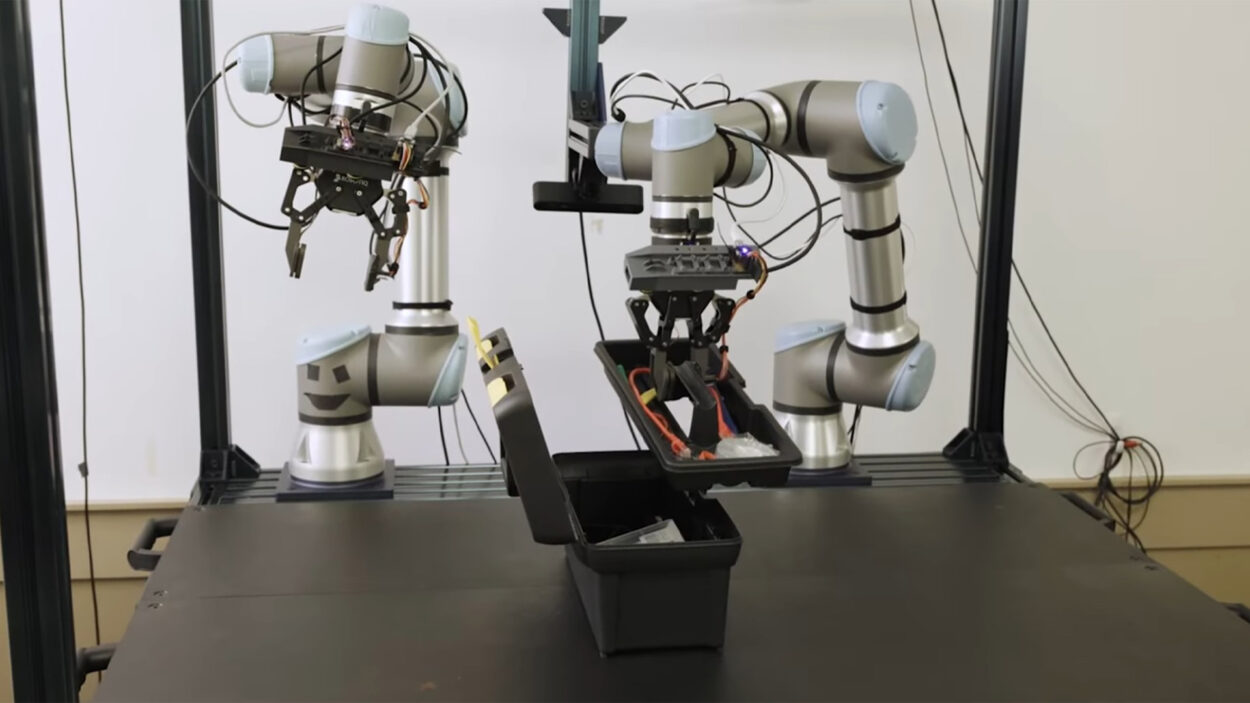

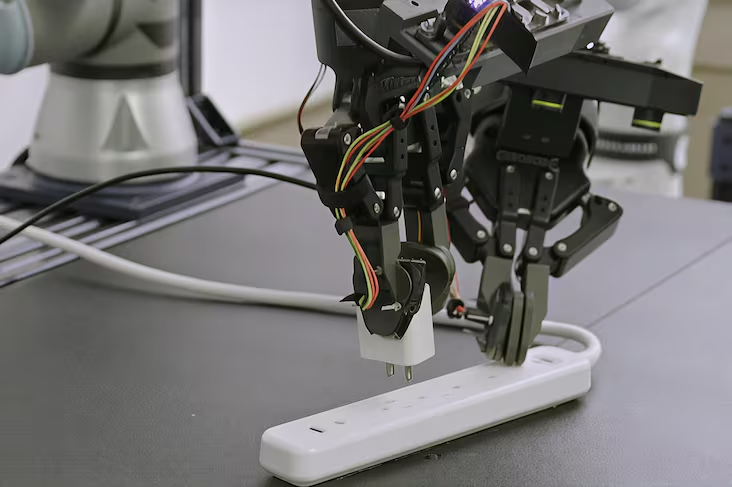

Dans sa forme actuelle, Rho-alpha cible des scénarios précis de manipulation bimanuelle, comme actionner des interrupteurs, brancher des prises ou manipuler une boîte à outils. Le modèle est déjà évalué sur des machines à deux bras et sur des robots humanoïdes, et fait l’objet d’un programme d’accès anticipé à la recherche, avant une mise à disposition ultérieure via Microsoft Foundry.

Une architecture VLA+ intégrant le toucher et l’apprentissage continu

Sur le plan technique, Rho-alpha est décrit comme un VLA+. Il s’agit d’un modèle vision-langage-action étendu, par rapport à des systèmes VLA classiques tels que Gemini Robotics 1.5 de Google ou Helix de Figure AI, entraîné à partir de vidéos humaines. Il conserve les fondations des VLA, tout en élargissant les modalités perceptives avec l’ajout de capteurs tactiles, et à terme de la mesure de force, encore en développement. Cette combinaison vise à réduire l’écart entre la perception visuelle et l’interaction physique fine, ce qui serait indispensable pour des tâches de manipulation réalistes.

L’entraînement du modèle repose sur un co-entraînement mêlant plusieurs types de données :

- des trajectoires issues de démonstrations physiques réelles,

- des trajectoires issues de tâches simulées,

- des jeux de données de questions-réponses visuelles à grande échelle.

Microsoft souligne également l’importance de l’apprentissage en situation, Rho-alpha étant conçu pour progresser lors de son déploiement grâce aux corrections humaines. Des opérateurs peuvent, par exemple, intervenir via des dispositifs de téléopération pour remettre un robot sur la bonne trajectoire. Des corrections dont le modèle tire ensuite des enseignements.

Cette capacité d’adaptation est présentée par Microsoft comme un marqueur clé de l’intelligence des systèmes robotiques, avec l’ambition de rendre les robots plus utiles et plus fiables dans des environnements partagés avec des humains.

Simulation, données synthétiques et rareté des données robotiques

L’un des défis majeurs mis en avant par Microsoft concerne la rareté des données robotiques à grande échelle, en particulier celles intégrant le toucher. Ce sont les données de simulation qui ont permis de contourner le problème. L’équipe a en fait généré des trajectoires synthétiques « physiquement réalistes » par apprentissage par renforcement, via la plateforme ouverte Nvidia Isaac Sim, exécutée sur Azure. Ces données simulées sont ensuite combinées à des jeux de données issus de démonstrations physiques.

« Entraîner des modèles fondamentaux capables de raisonner et d’agir nécessite de surmonter la pénurie de données réelles diversifiées », résume Deepu Talla, vice-président de la robotique et de l’IA embarquée chez Nvidia.

De son côté, Abhishek Gupta, professeur assistant à l’université de Washington, souligne que « la génération de données d’entraînement par téléopération de systèmes robotiques est devenue une pratique standard », tout en rappelant que de nombreux contextes rendent cette téléopération impraticable, d’où l’intérêt des démonstrations synthétiques.

Avec Rho-alpha, Microsoft ne prétend pas résoudre l’ensemble des défis de la robotique autonome, mais propose une brique fondationnelle orientée vers l’adaptabilité et la manipulation complexe. En combinant vision, langage, toucher, simulation et supervision humaine, le groupe explore une voie hybride pour faire sortir les robots des environnements industriels ultra-contrôlés. Une étape supplémentaire vers des machines capables de s’ajuster aux situations imprévues du monde réel. Et vous, pensez-vous que les robots pourront, un jour, avoir la même perception de leur environnement que nous ?

Certains liens de cet article peuvent être affiliés.