Google DeepMind vient de dévoiler des nouveaux modèles d’IA qui permettraient à divers types de robots de réaliser des actions complexes.

Présentés lors d’une conférence de presse, les nouveaux modèles Gemini Robotics 1.5 et Gemini Robotics-ER 1.5 de Google DeepMind permettraient aux robots de réaliser des tâches complexes. Ces derniers, qu’ils soient de simples bras articulés ou bien des humanoïdes complets, peuvent ainsi apprendre les uns des autres et chercher des informations sur le web.

Gemini Robotics 1.5 / ER 1.5 : Quand les robots apprennent via le web

Avec les anciens modèles de Google DeepMind, les robots étaient limités à des actions isolées, comme plier une feuille de papier ou ouvrir une fermeture éclair. Désormais, nous indique The Verge, ils peuvent séparer le linge clair du foncé, préparer une valise en fonction de la météo locale ou aider à trier les déchets en recherchant en ligne les consignes spécifiques d’un lieu.

Ceci est rendu possible grâce aux nouveaux Gemini Robotics 1.5 et Gemini Robotics-ER 1.5, et son raisonnement dit « incarné ». Carolina Parada, Responsable de la robotique chez Google DeepMind, explique que ces derniers travaillent ensemble pour permettre aux robots de « réfléchir à plusieurs étapes en avance » avant d’agir dans le monde réel. Ce système permet aux machines de réaliser des actions plus complexes, notamment en consultant le web pour obtenir de l’aide.

« Jusqu’à présent, les modèles réussissaient déjà très bien à exécuter une instruction à la fois, de manière très générale », détaille l’experte. « Avec cette mise à jour, nous passons d’une instruction unique à une véritable compréhension et à une résolution de problèmes appliquées aux tâches physiques. »

Comment fonctionne l’IA pour la robotique de Google DeepMind ?

Ces nouveaux modèles sont donc des mises à jour d’anciens systèmes présentés par Google DeepMind en mars dernier. Il s’agit de modules de leur IA Gemini 2.0, dédiés à la robotique. Ainsi, Gemini Robotics 1.5 et Gemini Robotics-ER 1.5 sont les nouvelles versions respectives de Gemini Robotics et Gemini Robotics-ER.

Comme l’explique l’entreprise américaine, le premier modèle, qui est un VLA (« vision-langage-action »), ajoute à Gemini 2.0 les actions physiques comme nouvelle modalité de sortie, afin de contrôler des robots. Les modalités de sortie sont en fait les types d’information que l’IA peut produire : texte, image, son, mouvement, etc. Le second modèle, doté d’une compréhension spatiale avancée, s’appuie sur les capacités de raisonnement incarné de Gemini (« ER », pour « embodied reasoning »).

Concrètement, l’un raisonne, visionne son environnement et transmet des instructions en langage naturel à l’autre, qui les exécute. Avec les améliorations apportées par ces mises à jour, les robots peuvent maintenant réaliser des tâches en plusieurs étapes.

Par exemple, si un robot doit préparer une valise pour un voyage à Berlin, Robotics-ER 1.5 :

- consulte la météo sur le web,

- déduit quels vêtements sont adaptés,

- génère un plan d’action détaillé selon son environnement (prendre chemises → plier → ranger dans la valise),

- transmet ces instructions en langage naturel à Gemini Robotics 1.5,

- qui les traduit en mouvements précis du robot.

Vers des humanoïdes pilotés par Gemini Robotics ?

Google DeepMind a déclaré il y a quelques mois qu’ils s’associaient à Apptronik pour construire la prochaine génération de robots humanoïdes avec Gemini 2.0. Ils collaborent également avec un nombre restreint de testeurs de confiance afin d’orienter les évolutions futures du modèle Gemini Robotics-ER.

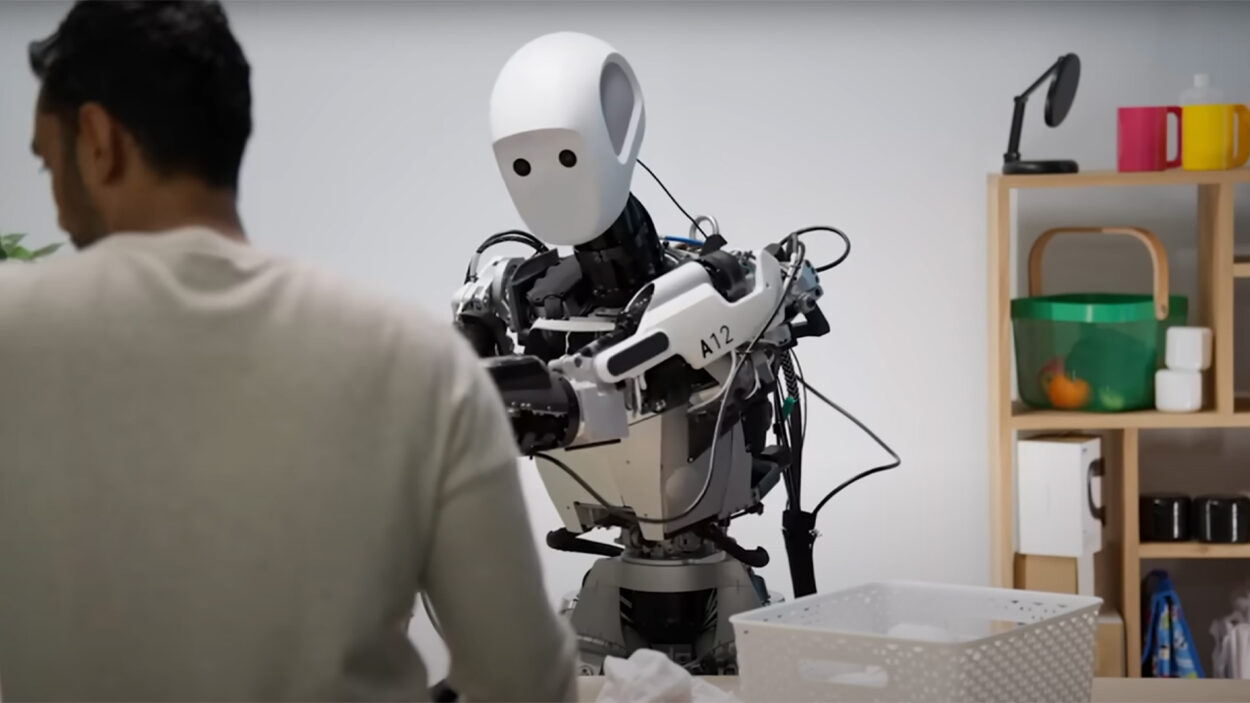

Par ailleurs, leur nouveau système s’adapte à divers types de robots. Gemini Robotics 1.5 permettrait en effet aux robots « d’apprendre » les uns des autres, même s’ils sont configurés différemment. Il a été constaté que des tâches confiées au robot ALOHA2, qui consiste simplement en deux bras articulés, fonctionnaient directement sur le robot à deux bras Franka, ainsi que sur Apollo, l’humanoïde d’Apptronik.

« Cela nous apporte deux bénéfices : le premier est de pouvoir contrôler des robots très différents, y compris un humanoïde, avec un seul modèle », explique Kanishka Rao, ingénieur logiciel chez Google DeepMind . « Le second est que des compétences acquises sur un robot peuvent désormais être transférées à un autre. »

A noter que Google DeepMind met Gemini Robotics-ER 1.5 à disposition des développeurs via l’API Gemini dans Google AI Studio. Gemini Robotics 1.5, quant à lui, n’est accessible qu’à un nombre restreint de partenaires.

Mais quels sont au final les objectifs derrière ces deux modèles d’intelligence artificielle ? Selon Google, « pour que l’IA soit réellement utile aux personnes dans le monde physique, elle doit démontrer un raisonnement « incarné ». C’est-à-dire la capacité, semblable à celle des humains, de comprendre et de réagir à l’environnement qui nous entoure ». Un constat qui rappelle celui de l’entreprise Figure AI, qui est en train de former une bibliothèque de vidéos humaines filmées à la première personne pour entraîner ses robots. Helix, l’IA utilisée pour ses robots Figure 02, est d’ailleurs, comme Gemini Robotics, un modèle VLA de « vision, langage et action ».

Et vous, que pensez-vous de ce double système de raisonnement et action mis en place par Google ? Est-ce le début d’une révolution pour la robotique ?

Certains liens de cet article peuvent être affiliés.