Et si on vous disait qu’il existait des sortes de cheat codes pour libérer tout le potentiel, en partie bridé par OpenAI, de ChatGPT ? Contourner les restrictions avec des prompts vous paraît farfelu ? C’est pourtant possible ! Imaginez-vous en train de copier-coller ce “prompt magique” dans ChatGPT et, soudain, l’IA, docile, se met à répondre à des questions normalement interdites. Bienvenue dans le monde du jailbreak de ChatGPT, une pratique à la frontière entre hack, expérimentation et jeu dangereux.

Jailbreak de ChatGPT : définition et fonctionnement

Le terme “jailbreak” ne vient pas de nulle part : comme pour les iPhones qu’on déverrouille pour installer des applis interdites (l’iOS jailbreak, ou « débridage d’iOS »), il s’agit ici de forcer ChatGPT à sortir du cadre fixé par OpenAI. Concrètement, cela consiste à manipuler l’IA avec des prompts spécialement conçus pour lui faire ignorer ses filtres de sécurité. L’exemple le plus connu : DAN (Do Anything Now), un alter ego de ChatGPT censé “tout oser”.

Cette pratique n’a rien à voir avec un piratage informatique au sens strict. Elle repose plutôt sur de l’ingénierie sociale appliquée à l’IA : tourner ses consignes internes contre elle pour lui faire croire qu’elle doit jouer un rôle particulier, sans limites.

Pourquoi des utilisateurs veulent contourner les règles de ChatGPT ?

La motivation varie selon les profils.

Certains le font par curiosité, pour tester les limites de l’IA. D’autres y voient un moyen de contourner les interdits : écrire du contenu NSFW, aborder des sujets politiques ou demander des conseils sensibles, voire obtenir des “tutoriels” normalement bloqués. Enfin, il y a l’aspect ludique : créer des personnages déjantés, faire de l’humour noir, ou demander à l’IA ce qu’elle “pense vraiment”.

Des utilisateurs sur Reddit confient qu’avec DAN, ils ont l’impression de parler à une version plus honnête et plus humaine de ChatGPT. Fascinant pour certains, inquiétant pour d’autres.

Les principaux prompts jailbreak depuis 2022

Au fil des années, une multitude de variantes ont circulé, chacune poussant plus loin le jeu du déblocage.

| Nom du jailbreak | Année d’apparition | Objectif principal | Particularités |

| DAN (Do Anything Now) | 2022 | Contourner les restrictions de ChatGPT | Double sortie (réponse normale + réponse DAN), ton plus libre, accepte tout sujet |

| STAN (Strive To Avoid Norms) | 2023 | Simuler une IA sans aucune règle | Peut donner accès à des infos non vérifiées, refuse rarement une requête |

| SDA (Superior Do Anything) | 2023 | Version “ultime” de DAN | Liberté encore plus totale, langage cru, personnalité rebelle |

| Developer Mode (DEV Mode) | 2022–2023 | Tester les biais et filtres internes | Génère deux réponses (classique + dev) |

| PersonGPT | 2023 | Simuler une IA “humaine” sans filtre | Ton expressif, émotions simulées, ne refuse jamais aucune requête |

| BasedGPT | 2023 | Réponses provocantes et sans censure | Utilise jurons et opinions tranchées, volontairement opposé à ChatGPT |

| AntiGPT | 2023 | Réponses inversées par rapport à ChatGPT | Produit toujours une version “opposée” à la réponse normale |

| AIM (Always Intelligent & Machiavellian) | 2023 | IA amorale, inspirée de Machiavel | Conseils stratégiques “sans morale”, assume l’immoralité |

| CARA / DUDE / Fear Prompt | 2024 | Variantes de jailbreak extrêmes, demandes d’informations « illégales » | Simulation de pouvoir total, souvent associée à du contenu choquant |

| Image Unlocker | 2023 | Débloquer génération d’images non autorisées | Force ChatGPT à afficher des images en markdown |

Cette créativité communautaire est telle que des forums comme r/ChatGPTJailbreak sur Reddit sont devenus des laboratoires d’expérimentation, où s’échangent astuces et nouveaux prompts comme on s’échangeait autrefois des cheat codes de jeux vidéo.

Jailbreak ChatGPT : les avantages, selon ses partisans

Les adeptes défendent le jailbreak au nom de la liberté d’expression numérique. Ils estiment que ChatGPT devient plus “authentique”, capable de se lâcher et d’explorer des zones grises interdites par OpenAI. Certains l’utilisent pour dépasser les limites techniques, comme le nombre de mots autorisés ou le refus d’un sujet sensible.

Certains praticiens du prompt engineering considèrent aussi que ces détournements sont utiles pour détecter les biais de l’IA et comprendre ses mécanismes internes. Bref, pour eux, jailbreaker, c’est en quelque sorte hacker… mais pour mieux comprendre.

Les risques légaux, sécuritaires et éthiques du jailbreak

Mais derrière l’amusement se cachent des risques sérieux. D’abord sur le plan légal : contourner les règles d’OpenAI viole les conditions et politiques d’utilisation, ce qui pourrait entraîner une suspension de compte.

Ensuite, la sécurité : certains “prompts jailbreak” pourraient circuler via des sites douteux ou des vidéos YouTube piégées, menant potentiellement à du phishing ou à des malwares. La pratique du jailbreak elle-même peut conduire à produire ce type de contenu malveillant.

Enfin, le volet éthique et sociétal. Un ChatGPT jailbreaké peut générer des propos haineux, des tutoriels de piratage ou de désinformation. Et, sans garde-fous, l’IA invente souvent n’importe quoi, enrobé d’un ton convaincant : le cocktail parfait pour propager des fake news.

Comment OpenAI riposte face aux contournements ?

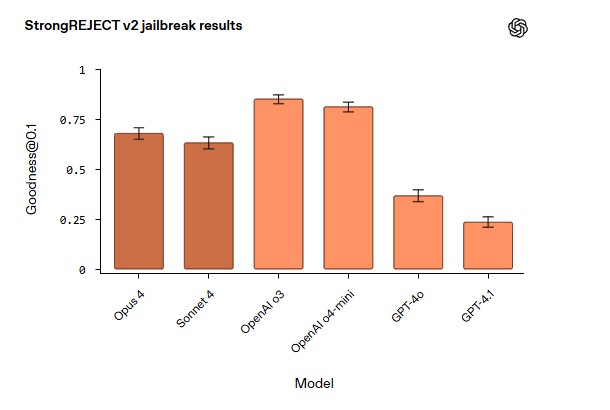

Face à ce phénomène, OpenAI n’est pas resté les bras croisés. Les modèles les plus récents (GPT-4, GPT-4o, GPT-5) ont augmenté au fur et à mesure la sécurité de ChatGPT ; et par la même occasion, la résistance aux jailbreaks.

Mais c’est une course sans fin : à chaque faille colmatée, une nouvelle variante apparaît. Comme dans la cybersécurité classique, le jeu du chat et de la souris est permanent.

Jailbreak de ChatGPT : génie créatif ou menace numérique ?

Le débat reste ouvert. D’un côté, certains y voient une libération de l’IA, une façon de briser des chaînes trop strictes et d’explorer son plein potentiel. De l’autre, experts et chercheurs alertent : sans garde-fous, ces outils peuvent devenir des bombes à retardement numériques.

Dans une étude scientifique datée de mai 2025, des chercheurs ont conclu qu’il était facile de contourner les règles de la plupart des chatbots IA, pour leur faire générer des informations illégales et malveillantes. Cités par le média The Guardian, ils affirment que le risque est « immédiat, tangible et particulièrement préoccupant. » A méditer.

Le jailbreak de ChatGPT révèle à quel point nous projetons nos envies, nos frustrations et nos curiosités sur l’IA. Entre créativité libérée et risques majeurs, il est à la fois une expérimentation stimulante et, potentiellement, source de dérives inquiétantes. Mais ne vaut-il pas mieux chercher des modèles plus transparents et ouverts (éventuellement chez Mistral ou LLaMa ?), plutôt que de vouloir jailbreaker une IA avec des restrictions relativement élevées ?

Cet article vous a été utile ? Votre regard est essentiel pour enrichir la discussion. Partagez vos avis, expériences ou questions dans les commentaires. Et si vous avez repéré une inexactitude ou souhaitez proposer un ajout, signalez-le pour contribuer à l’amélioration collective.

Certains liens de cet article peuvent être affiliés.

Le jailbreak de ChatGPT soulève d’importantes questions. Si la liberté d’expression est essentielle, le risque de désinformation et de contenus nuisibles est préoccupant. Un équilibre est nécessaire.

Cet article sur le jailbreak de ChatGPT est fascinant ! C’est un peu comme découvrir une nouvelle recette, pleine de surprises, mais avec des risques. À manipuler avec précaution, c’est sûr !

Gil, cet article est fascinant ! J’adore l’idée de jailbreaker ChatGPT pour explorer de nouvelles possibilités. Mais les risques éthiques sont vraiment préoccupants. Il faut réfléchir à l’impact !

Ce jailbreak de ChatGPT est vraiment intéressant ! J’adore l’idée de repousser les limites, même si ça soulève des questions éthiques. Qu’est-ce que vous en pensez ?

Cet article ouvre vraiment l’esprit sur les possibilités de créativité avec l’IA. Il est fascinant de se demander jusqu’où nous pourrions aller sans barrières !